L'Agence de presse de l'innovation

Doper la transformation numérique des entreprises grâce au tandem Cloud native / IA

Combiner les technologies du Cloud native et de l’intelligence artificielle (IA) aide les entreprises à accélérer le déploiement d’applications enrichies. A condition de poursuivre les efforts en matière de cybersécurité et d’anticiper les processus de maîtrise de la dépense.

Article publié dans Les Echos - Le 12 novembre 2024

Attention à ce que la facture électrique de l’IA ne soit pas trop salée

L’intelligence artificielle (IA) consomme de plus en plus d’électricité. Les modèles Open Source d’IA pourraient contenir cette croissance. Entretien avec Stéphane Fermigier, co-président du Conseil national du logiciel libre (CNLL) qui fédère plus de 200 entreprises du numérique libre (ENL).

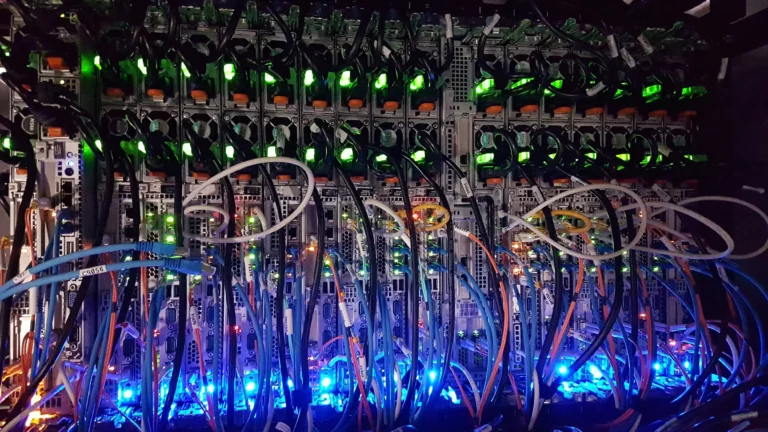

La croissance de la consommation de données numériques dans le monde, passant de 64 zettaoctets (trilliards d’octets) [https://starry-com.translate.goog/blog/inside-the-internet/whats-after-terabytes-and-petabytes?_x_tr_sl=en&_x_tr_tl=fr&_x_tr_hl=fr&_x_tr_pto=rq] en 2020 à 180 zettaoctets en 2025 d’après Statista [https://fr.statista.com/infographie/17800/big-data-evolution-volume-donnees-numeriques-genere-dans-le-monde/], s’accompagne d’une explosion de la consommation électrique des centres de données. Celle-ci devrait bondir de 57 GW en 2023 à 93 GW en 2028, selon un rapport de Schneider Electric [https://www.se.com/ww/en/download/document/SPD_WP110_EN/].

En témoignent les deux plus grands projets de Data Centers actuellement en construction dans notre pays : 40 000 m² pour celui d’Interxion à La Courneuve (Seine-Saint-Denis) et 60 000 m² à Lisses (Essonne) pour celui CloudHQ qui prévoit une puissance électrique de 240 MW ! Dans le monde, la part électrique de l’IA augmente de 8 % à une fourchette comprise entre 15 % et 20 % sur la période, soit de 4,5 GW 18,7 GW.

Gourmande phase d’entraînement des modèles d’IA

« La capacité de calcul pour entrainer les modèles d’IA, notamment les grands modèles de langage (LLM) comme ChatGPT, requiert typiquement de milliers de cartes graphiques (GPU) pendant plusieurs semaines », souligne Stéfane Fermigier [https://www.lesechos.fr/2017/12/la-france-championne-deurope-de-lopen-source-2031844], co-président du Conseil national du logiciel libre (CNLL) [https://cnll.fr/] qui fédère environ 200 entreprises du numérique libre (ENL).

Quant à la consommation électrique de l’entraînement des modèles, Schneider Electric l’évalue actuellement à 20 % contre 80 % pour la phase d’exploitation du service (inférence) dont la durée de vie est bien plus longue.

© Massimo Botturi / Unsplash

Des modèles Open Source d’IA déjà entraînés

« Selon la complexité du modèle et celle de la tâche qu’il aura à exécuter ainsi que selon le nombre de requêtes, sa consommation énergétique durant la phase d’inférence sera plus ou moins élevée », ajoute le co-président du CNLL. Bonne nouvelle : l’Open Source Initiative [https://opensource.org/] vient de publier, fin octobre, la toute première définition des modèles d’IA libres [https://opensource.org/blog/the-open-source-initiative-announces-the-release-of-the-industrys-first-open-source-ai-definition].

Conséquence : sur les places de marché de modèles d’IA Open Source comme Hugging Face [https://huggingface.co/], qui, début octobre, a franchi la barre du million de modèles d’IA hébergés, les développeurs peuvent utiliser des modèles existants déjà entraînés couvrant des tâches telles que le traitement du langage naturel (traduction, résumé automatique, extraction d’entités nommées, génération de textes…), la vision par ordinateur, etc.

« Ces modèles génériques réutilisables s’adaptent facilement à des besoins plus spécifiques. De quoi réduire la consommation énergétique de leur phase d’entraînement et les rendre plus frugaux », poursuit Stéfane Fermigier. Ajoutons que la disponibilité des modèles Open Source marque l’engagement de la communauté du logiciel libre pour démocratiser les usages de l’IA.

Cependant, une question reste en suspend : « Les organisations utilisatrices d’IA sauront-elles mettre en œuvre l’ingénierie financière nécessaire pour calculer les coûts de l’usage du Cloud ? », soulève Stéfane Fermigier.

© Erick Haehnsen / Agence TCA