L'Agence de presse de l'innovation

ChatGPT, générateur d’arnaques

Article publié dans le site d'actualités Infoprotection.fr - Le 16 février 2023

L’expert en cybersécurité McAfee vient de publier un communiqué dans lequel il alerte sur les utilisations frauduleuses générées par l’usage du chatbot ChatGPT.

Écrivain en mal d’inspiration, étudiants voulant accélérer la rédaction de leurs devoirs, paroliers de chansons au mètre ou amoureux éplorés… L’émergence de l’IA conversationnelle d’OpenAI, ChatGPT, a su conquérir de nombreux utilisateurs du net. Il faut dire que ce générateur de texte par l’intelligence artificielle est capable de produire des contenus ciblés et d’en augmenter l’intensité dramatique ou le caractère urgent. Or, comme toute technologie émergente, ce chabot peut également être utilisé à mauvais escient. En témoigne l’expert en cybersécurité McAfee qui vient de publier une note dans laquelle il liste quelques utilisations malveillantes possibles des générateurs de texte d’IA.

Écriture de codes malveillants

Premier risque, ChatGPT est capable d’écrire des codes malveillants. Pour les cyberpirates, cela représente même une aubaine car son IA peut générer des logiciels malveillants polymorphes. Il s’agit d’un type de programme en évolution permanente, donc difficile à détecter et à neutraliser. La rédaction de codes s’avère une opération laborieuse et chronophage. D’où l’intérêt pour les pirates d’utiliser le ChatGPT comme machine à écrire automatique qui fonctionne 24 heures sur 24.

Des faux profils de rencontre

Autre menace, les personnes qui créent de faux profils en ligne se servent du chatbot pour affiner leur stratégie de séduction. À l’instar des créateurs de logiciels malveillants qui utilisent l’IA pour augmenter leur production, les escrocs peuvent ainsi diminuer leur charge de travail.

Des arnaques plus crédibles

Outre la possibilité de gérer plusieurs profils de rencontre à la fois, ChatGPT est capable de modifier le ton des messages. Par exemple, l’IA peut rédiger une lettre d’amour et en augmenter le charme. De quoi augmenter la crédibilité de ces fausses déclarations d’amour pour convaincre une victime. L’objectif : l’inciter à dévoiler ses informations personnelles identifiables (PII) ou lui soutirer de l’argent.

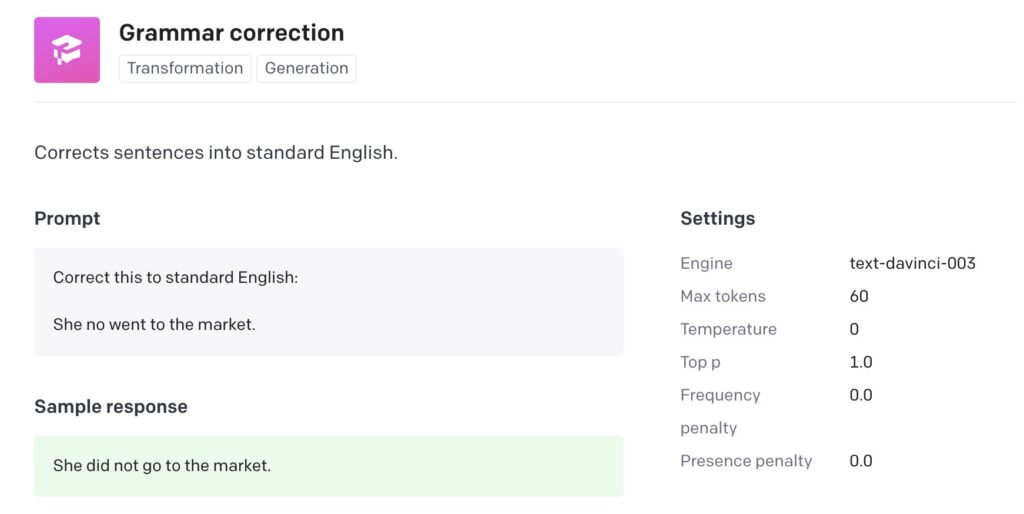

Un hameçonnage agressif

Par ailleurs, l’IA peut également servir aux hameçonneurs. Connus pour leurs fautes de grammaire et d’orthographe, ces escrocs peuvent corriger leurs messages grâce au chatbot, peu enclin aux erreurs de rédaction. ChatGPT inclut également les commandes de tonalité, ce qui permet d’intensifier l’urgence de leurs requêtes. Par exemple pour exiger un paiement immédiat ou des informations personnelles.

Accroître la vigilance

Selon McAfee, pour se prémunir de ces arnaques, il faut avant tout rester en alerte et examiner minutieusement chaque contenu envoyé par un inconnu. Certains signes peuvent s’avérer révélateurs d’un message écrit par l’IA et trahir son auteur. Par exemple, l’IA se sert généralement de phrases courtes et réutilise les mêmes mots.

Des messages généralement vagues

De plus, l’IA créée du contenu, certes, mais qui peut paraître inconsistant. Étant donné que l’algorithme se révèle incapable de se forger sa propre opinion, ces messages peuvent sembler sans substance. Enfin, dans le cas des arnaques à la romance, un interlocuteur qui refuse une rencontre en personne ou de discuter par vidéo, pourrait bien être un escroc.

Segolene Kahn